Silent AI.

100% local. 100% secure. 100% yours.

Nutzen Sie KI-Power ohne Datenschutz-Risiken - 100% DSGVO-konform aus Deutschland.

Ich möchte den Einsatz von Kl im Unternehmen vorantreiben, um die Effizienz meiner Teams zu steigern. Datenschutz und Sicherheit haben höchste Priorität.

Wie stelle ich sicher, dass unsere Daten trotzdem geschützt bleiben?

Das ist genau mein Spezialgebiet:

Silent Al läuft vollständig lokal in deinem Rechenzentrum - ohne Cloud, ohne Datenabfluss. Kein Risiko durch den US CLOUD Act, keine externe Verarbeitung: Alles bleibt intern. Verschlüsselt, nachvollziehbar und DSGVO-konform - für maximale Sicherheit und Vertrauen.

Deine Daten bleiben dort, wo sie hingehören: bei dir.

"Es spielt für mich persönlich immer mehr eine Rolle, ob ein Hersteller europäisch ist. Alles, was aus den USA kommt, muss man mittlerweile kritisch sehen, sei es wegen der Kosten oder auch wegen des Datenschutzes."

Michael Günther, IT-Leiter der Gesundheitsholding Werra-Meißner

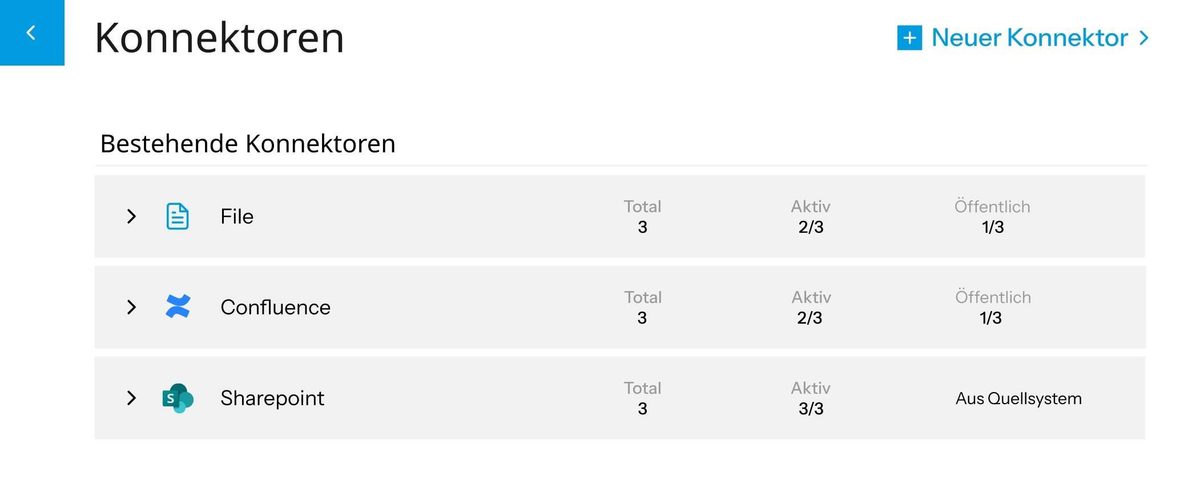

Über unsere Konnektoren integrieren Sie Ihre Workplace-Anwendungen in Silent AI

Was ist Silent AI?

Silent AI ist eine lokale Appliance, die sich nahtlos in Ihre Arbeitsumgebung integriert und individuelle, datensouveräne KI-Unterstützung bietet.

Dabei ist sie mit Ihren bevorzugten Workplace-Anwendungen verknüpft und verfügt so Zugang zu Ihrem internen Wissen, ohne dass dieses Ihr Unternehmen verlässt. Zudem respektiert Silent AI Ihr bestehendes Rechte-Management, um Missbrauch und Fehlinformationen zu vermeiden. Alle Antworten werden mit konkreten Quellenangaben versehen, über die Sie direkt zu den Informationen in der entsprechenden Anwendung gelangen.

Mit Silent AI werden Ihre Teams effizienter und gelangen schneller an die relevanten Informationen – ohne, dass sensible Unternehmensdaten irgendwo hochgeladen werden und unter Berücksichtigung der aktuellen und kommenden Gesetzeslage.

Aus Deutschland.

Silent AI wird in Deutschland entwickelt – mit höchstem Anspruch an Qualität, Zuverlässigkeit.

Sicher & effizient.

Die hochsichere, energieeffiziente Off-Cloud-KI-Appliance mit 10 Jahren Wartung. Die Appliance erfüllt alle deutsche und europäische Regularien (DSGVO, EU AI Act).

Integriert.

Erhalten Sie präzise Antworten aus jeder Ecke Ihrer Unternehmens-Wissensdatenbank – dank vielseitiger Konnektoren, die Informationen sicher und effizient zusammenführen.

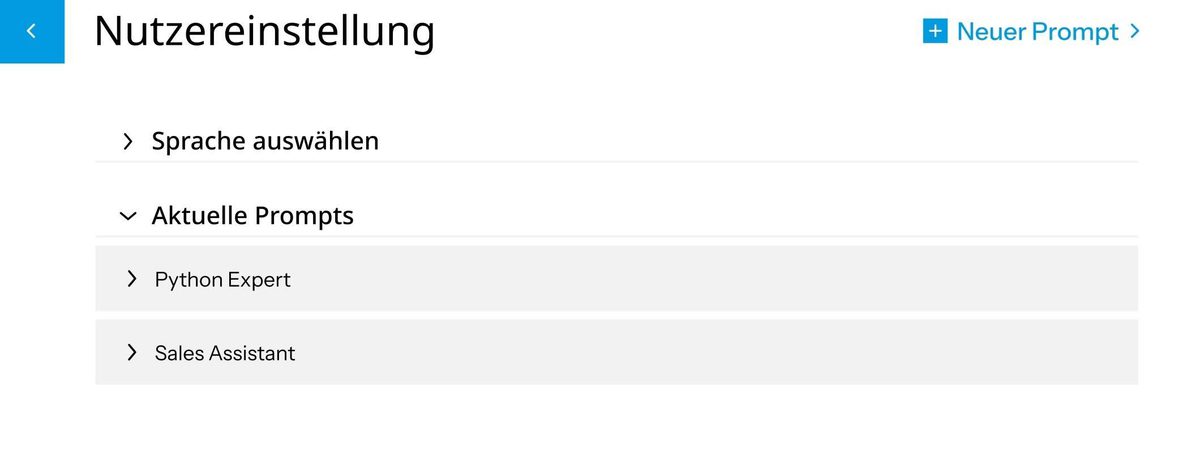

Persönlich & individuell.

Gestalten Sie Ihren individuellen KI-Assistenten. Durch eigene Prompts als Initialkonfiguration passen Sie das Verhalten der KI gezielt an verschiedene Fachbereiche an – für konsistente und maßgeschneiderte Antworten.

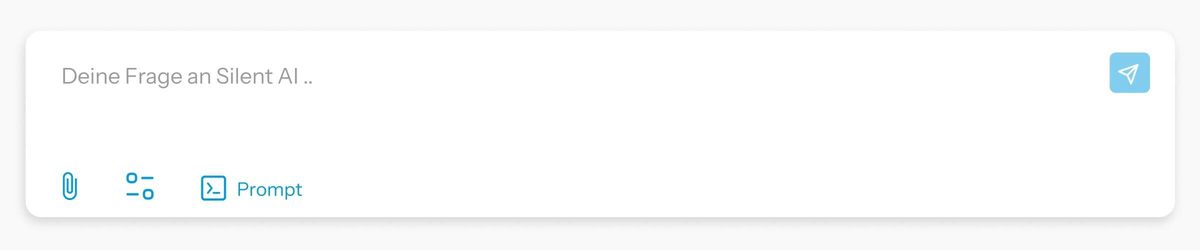

Sofort nutzen.

Die intuitive Oberfläche macht den Einstieg leicht und verwandelt jeden im Handumdrehen in einen Wissensexperten. Wissen auf Knopfdruck, für alle sofort zugänglich.

Warum ist Silent AI für Sie geeignet?

Privat.

Silent AI ist off-Cloud und läuft autark als Appliance in Ihrem Unternehmen. Weder Daten noch Fragen oder Antworten verlassen Ihr Unternehmen. Ihr vorhandenes Rechte-Management wird von Silent AI respektiert, so dass Ihre Mitarbeiter weiterhin nur Zugang zu den freigegebenen Bereichen und Daten haben. Der Inkognito-Modus schützt besonders sensible Anfragen zusätzlich.

Verbunden.

Anstatt Ihre sensiblen Daten irgendwo hochladen zu müssen, verbinden Sie Silent AI lokal mit Ihren Workplace-Anwendungen. So hat Silent AI Zugriff auf Ihre Daten, ohne dass diese jemals Ihr Unternehmen verlassen. Antworten werden aus den bereitgestellten Datensätzen generiert und nicht durch irgendwelche zufälligen Informationen aus dem Internet ausgedacht.

Einfach.

Silent AI funktioniert so einfach wie eine KI-Suche. Sie fragen in normaler Sprache und erhalten ausformulierte Antworten statt seitenlanger Suchergebnisse. Quellenangaben verweisen direkt auf die genutzten Informationsquellen – ob öffentlich verfügbar oder nur in Ihrem Unternehmen.

Der KI-Booster für alle Teams.

Deals schneller abschließen

- Kundenhistorie & Vertriebsunterlagen in Sekunden finden: Kein langes Suchen nach alten E-Mails, Angeboten oder Vertragsdetails. Silent AI durchsucht alle Daten, Präsentationen und Verhandlungsprotokolle – und liefert die relevanten Infos bevor der Kunde nachfragt.

- Wettbewerbsanalysen auf Knopfdruck: Aktuelle Marktinformationen, Preismodelle der Konkurrenz oder Success Stories aus vergangenen Projekten – immer griffbereit.

Berichte & Compliance ohne Chaos

- Rechnungen, Verträge und Audit-Dokumente in Sekunden: Kein manuelles Durchforsten von Ordnern. Die KI erkennt Zusammenhänge zwischen Zahlen, Verträgen und Richtlinien.

- Steuerrechtliche Änderungen im Blick: Aktuelle Gesetze oder interne Richtlinien werden proaktiv verknüpft – Compliance-Risiken minimieren.

Wissen bündeln, Lernen erleichtern

- Digitale Wissensplattform, Forschungsarbeiten und Verwaltungsmaterialien in Sekunden finden: Kein langes Durchsuchen von verschiedenen Plattformen, PDFs oder Cloud-Ordnern. Silent AI vereint alle relevanten Inhalte und liefert sofort die richtigen Informationen.

- Effiziente Verwaltung: Protokolle, Richtlinien und interne Abläufe werden strukturiert durchsuchbar – so sparen Fakultäten und Verwaltungsmitarbeitende wertvolle Zeit.

Schnellere Diagnosen, weniger Dokumentationsstress

- Patientenakten & Befunde in Sekunden: Kein Blättern in Papierakten oder Klicken durch verschiedene Systeme. Die KI durchsucht Laborergebnisse, Röntgenbilder, Arztbriefe und Medikationspläne – und liefert relevante Vorerkrankungen oder Allergien direkt im Kontext.

- Leitlinien & Studien auf Knopfdruck: Aktuelle Behandlungsempfehlungen (z. B. zu seltenen Erkrankungen) oder Krankenhausinterne Protokolle werden während der Visite angezeigt – für evidenzbasierte Entscheidungen.

Kampagnen mit Datenkraft beschleunigen

- Content-Ideen & Assets blitzschnell lokalisieren: Ob alte Blogposts, Social-Media-Stats oder Kundenzitate – die KI findet inspirierende Inhalte für neue Kampagnen.

- Zielgruppen-Insights ohne Recherche-Marathon: Analysen, Personas und Erfolgsmetriken vergangener Kampagnen werden automatisch verknüpft – für datengetriebene Entscheidungen.

Support-Tickets in Rekordzeit lösen

- Lösungen aus vergangenen Fällen vorschlagen: Die KI durchsucht alle bisherigen Tickets, Chatverläufe und Wissensartikel – und schlägt die beste Antwort vor.

- Wissenslücken im Team schließen: Neue Mitarbeiter finden sofort die richtigen Antworten – ohne langes Einarbeiten.

Demo-Termin

Vereinbaren Sie einen Demo-Termin mit unseren Experten und lassen Sie sich überzeugen.

Risiken und Schwächen herkömmlicher KI-Systeme

Unsichere Cloud KI-Systeme:

In der Cloud betriebene KI-Lösungen bergen Datenschutz- und Sicherheitsrisiken. Besonders amerikanische Dienstleister unterliegen dem US CLOUD Act und Datenschutzrisiken.

Ineffizienz & Ungenauigkeit:

Ohne KI kann man nicht mehr wettbewerbsfähig sein. Standard-KI durchsucht Daten jedoch oft unstrukturiert und liefert unzuverlässige Ergebnisse.

Veraltete Informationen & Wissensverlust:

Wissensmanagement-Systeme werden selten gepflegt. Beim Ausscheiden von Mitarbeitern geht oft viel Wissen verloren oder wird vergessen.

Zersplitterte Datenquellen:

Informationen liegen verteilt in verschiedenen Systemen und Formaten vor und sind schwer zu finden oder zu verknüpfen, was zeitaufwendig und kostspielig sein kann.

Silent AI ist privat, individuell und besonders sicher.

Souverän & sicher:

100 % Off-Cloud, volle Datenhoheit, Ende-zu-Ende-verschlüsselt.

Effizient & präzise:

Optimierte RAG-Struktur, interdisziplinär getestet.

Rechtestrukturen integriert:

Zugriff nur für autorisierte Nutzer.

APIs & Konnektoren:

Flexible Integration in bestehende Systeme.

Stets aktuell:

Dynamische Datenaktualisierung.

Alle Quellen vereint:

Einheitlicher, sicherer Wissenszugang.

Lesestoff

…garantiert KI-frei.

Daten sind der Treibstoff der digitalen Welt – und gleichzeitig ein strategisches Gut im geopolitischen Wettbewerb. Während sich Unternehmen und öffentliche Einrichtungen zunehmend auf KI stützen, wächst die Sorge vor technologischer Abhängigkeit und Kontrollverlust. Die geopolitische Dimension von Datenschutz und Datensicherheit für europäische Unternehmen lässt sich im Wesentlichen auf drei zentrale Aspekte reduzieren…

Künstliche Intelligenz (KI) ist längst kein abstraktes Zukunftskonzept mehr – sie ist zum entscheidenden Treiber für Innovation und Effizienz in allen Wirtschafts- und Gesellschaftsbereichen geworden. Von der Automobilindustrie über Krankenhäuser bis hin zu Behörden und Schulen setzen Organisationen KI-Systeme ein, um Prozesse zu optimieren, Entscheidungen datenbasiert zu treffen und neue Geschäftsmodelle zu entwickeln. Laut einer Studie von McKinsey kann generative KI bis zu 60–70% der Arbeitszeit bei Routineaufgaben automatisieren und die globale jährliche Produktivität bis 2040 um 0,1 bis 0,6 Prozentpunkte steigern. Gleichzeitig zeigt der Bildungssektor mit einer 86 %igen Nutzungsrate KI-gestützter Tools unter Studierenden, wie tief die KI-Technologie bereits in den Alltag von Menschen integriert ist.

Mit der zunehmenden Verbreitung Künstlicher Intelligenz wächst auch die Verantwortung, diese Technologien sicher, rechtskonform und vertrauenswürdig einzusetzen. Die Datenschutz-Grundverordnung (DSGVO) stellt dabei hohe Anforderungen an den Umgang mit personenbezogenen Daten. Der kommende EU AI Act geht noch einen Schritt weiter und definiert strenge Vorgaben – insbesondere für sogenannte Hochrisiko-Anwendungen, wie sie im Gesundheitswesen oder in öffentlichen Diensten zum Einsatz kommen. In diesem Kontext rücken On-Premise-KI-Lösungen europäischer Anbieter in den Fokus: Sie bieten nicht nur technologische Souveränität, sondern auch eine strategische Antwort auf aktuelle geopolitische Spannungen.